人工智能学会了看懂动作! 复旦大学团队的视频识别新突破

- 2025-08-06 04:25:10

- 235

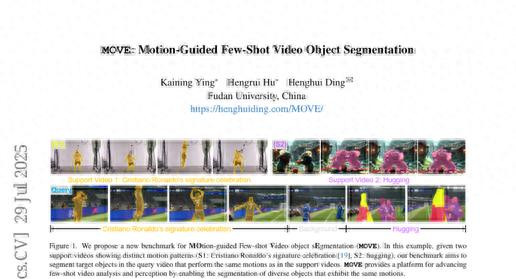

当你在网上看到C罗标志性的庆祝动作时,你的大脑会立刻识别出这是那个熟悉的"SIU"姿势,即使做这个动作的不是C罗本人。这种根据动作模式而非外貌来识别对象的能力,正是复旦大学研究团队最新开发的人工智能系统所具备的核心技能。

这项由复旦大学计算机科学与人工智能学院的应开宁、胡恒瑞和丁恒慧等研究者共同完成的研究,发表于2025年7月的国际计算机视觉大会(ICCV),论文标题为"MOVE: Motion-Guided Few-Shot Video Object Segmentation"。感兴趣的读者可以通过https://henghuiding.com/MOVE/访问完整的研究资料和数据集。

过去的视频识别系统就像一个只会认脸的门卫,它们主要关注"这是什么东西",比如识别出画面中有猫、有人或有车。但现实生活中,我们经常需要根据"在做什么动作"来找到我们想要的内容。就好比你想在海量视频中找到所有"拥抱"的场景,传统系统可能只能帮你找到特定的人或动物,却无法理解拥抱这个动作本身的含义。

复旦大学的研究团队意识到了这个问题的重要性。他们发现,当我们在网上搜索视频时,往往是想找到某种特定的动作或行为,而不仅仅是某个特定的物体。比如,你可能想找到所有踢足球的视频片段,不管踢球的是成人还是儿童,是在草地上还是在沙滩上。这种需求在视频编辑、体育分析、安防监控等领域都非常常见。

为了解决这个挑战,研究团队开发了一个名为MOVE的全新数据集和相应的人工智能模型。这个系统的工作原理可以用一个生动的比喻来解释:就像一个经验丰富的舞蹈老师,能够通过观看几个学生的示范动作,然后在一群人中准确识别出哪些人在做同样的舞蹈动作,即使这些人的身材、衣着和面貌完全不同。

一、突破传统认知框架的全新方法

传统的视频识别系统面临的最大问题,就像是一个只会通过外貌识别人的系统。这种方法在很多情况下都会遇到困难。考虑这样一个场景:你有两段视频,一段是一只猫在弹钢琴,另一段是一个人在吹长笛。传统系统会认为这两段视频完全不相关,因为一个是猫,一个是人。但在人类看来,这两段视频其实都展现了"演奏乐器"这个共同的动作模式。

复旦大学团队的创新之处在于,他们让人工智能系统学会了像人类一样思考。他们的系统不再只关注"是什么",而是重点关注"在做什么"。这就好比训练一个侦探,不是让他记住每个罪犯的长相,而是让他学会识别各种犯罪行为的模式和特征。

这种方法的革命性在于它改变了我们思考视频理解的基本框架。过去,我们总是先识别物体,再分析行为。现在,这个系统直接从动作模式入手,把动作本身当作识别的核心特征。这就像是从"认人"转向了"认行为",从静态识别转向了动态理解。

研究团队还发现了传统方法的另一个重要局限:现有的视频理解系统主要依赖静态图像的分析,就像通过一张张照片来理解一部电影的情节。这种方法显然无法捕捉到动作的时间特性和连续性。真正的动作理解需要考虑时间维度,需要理解动作的发展过程和变化规律。

二、构建动作理解的数据基础

为了训练这样一个能够理解动作的人工智能系统,研究团队面临的第一个挑战就是缺乏合适的训练数据。现有的数据集就像是为传统识别任务量身定做的教科书,对于动作理解这个新任务来说远远不够。

于是,研究团队着手构建了一个名为MOVE的大规模数据集。这个数据集的规模令人印象深刻:包含224个不同的动作类别,涵盖4300个视频片段,总共261920帧画面,以及314619个精确标注的分割掩码。这些数字背后代表着研究团队巨大的工作量和严谨的学术态度。

MOVE数据集的构建过程就像是编写一本动作百科全书。研究团队将动作分为四个主要领域:日常行为、体育运动、娱乐活动和特殊动作。每个类别都遵循三个重要原则:细粒度区分、互相排斥(有清晰的语义边界)、以及新颖性(在现有数据集中覆盖不足)。

这种分类方法的巧妙之处在于它考虑了动作的层次性和复杂性。比如在体育运动类别中,不仅包括踢足球、打篮球这样的大类动作,还细分到运球、射门、防守等具体的子动作。这种精细化的分类使得人工智能系统能够学习到更加准确和具体的动作模式。

数据收集的过程同样严谨。研究团队从两个主要来源获取视频:一是公开的动作识别数据集,二是符合创作共用许可协议的网络视频。在选择过程中,他们严格遵循三个标准:视频必须有清晰的动作边界、场景要多样化、主体类别要丰富。这样的标准确保了数据集的质量和多样性。

对于没有现成标注的视频,研究团队还招募了训练有素的标注员,在交互式标注平台上借助先进的视频分割模型来制作高质量的掩码标注。这个过程就像是为每个动作制作精确的"身份证",让人工智能系统能够准确理解什么是目标动作,什么不是。

三、解耦动作与外观的创新算法

有了丰富的训练数据,下一个挑战就是如何设计一个能够真正理解动作的算法。这里的核心难题在于如何让系统区分物体的外观特征和动作特征。这就好比教一个学生区分一个人的长相和这个人的行为方式,虽然两者都很重要,但在不同的任务中重要性不同。

研究团队提出的解决方案是一个名为"解耦动作-外观网络"(DMA)的创新算法。这个算法的基本思想是将视频中的信息分解为两个独立的部分:一部分专门负责理解物体的外观特征,另一部分专门负责理解动作特征。

这种解耦的方法可以用一个生动的比喻来理解。在一个舞蹈教室里,有经验的舞蹈老师能够同时关注两个方面:学生的外形特征(身高、体型、衣着)和舞蹈动作本身(步伐、节奏、姿态)。当老师需要评价舞蹈技巧时,会重点关注动作特征而相对忽略外形差异。DMA算法正是模拟了这种人类的认知过程。

在技术实现上,DMA算法采用了一种巧妙的设计。对于外观特征的提取,系统使用传统的掩码池化方法,就像拍摄一张静态照片来记录物体的外观。而对于动作特征的提取,系统则计算相邻帧之间的时间差异,通过3D卷积网络来捕捉动作的时间演变过程。这就像制作一个动态的"动作指纹",记录下动作的时间特征。

为了确保这两种特征真正独立且互补,研究团队还设计了两个辅助的分类头。一个分类头专门负责物体类别的识别,引导外观特征学习物体的静态属性。另一个分类头专门负责动作类别的识别,引导动作特征学习时间动态信息。这种设计就像给两个学生分配不同的学习任务,确保他们各自专精于不同的领域。

算法的另一个创新点是使用了Transformer架构来进一步细化动作原型。这个过程包括多层的交叉注意力机制和自注意力机制,能够捕捉动作特征之间的复杂关系。简单来说,这就像一个经验丰富的教练,能够从复杂的动作序列中提取出最关键的动作要素,形成标准化的动作模板。

四、验证效果的综合实验

为了验证MOVE数据集和DMA算法的有效性,研究团队进行了大规模的对比实验。他们选择了来自三个不同研究领域的六种最先进的方法进行比较,包括指称视频目标分割方法、少样本图像分割方法和少样本视频目标分割方法。

实验设计采用了两种不同的数据分割策略。重叠分割策略允许训练集和测试集在动作的高层类别上有一定重叠,这模拟了相对简单的泛化场景。非重叠分割策略则要求测试集中的动作类别与训练集完全不同,这代表了更加严格的泛化测试。

实验结果令人印象深刻。在重叠分割的2路1样本设置下,DMA算法在ResNet50骨干网络上达到了50.1%的J&F得分,相比第二名的45.4%有显著提升。当使用更强的VideoSwin-T骨干网络时,性能进一步提升到51.5%。在更困难的5路1样本设置下,DMA同样保持了显著的领先优势,达到了40.2%的得分。

这些数字背后的意义可以这样理解:如果把视频分割的准确性比作射箭比赛,那么DMA算法就像一个经验丰富的射手,即使在不同的风向和距离条件下,仍然能够保持稳定的高命中率。特别是在更困难的非重叠分割设置下,DMA仍然能够达到46.0%的得分,证明了其强大的泛化能力。

研究团队还进行了详细的消融实验来验证算法各个组件的贡献。他们发现,基于帧差分的动作提取方法比简单的掩码池化方法效果更好,将性能从41.3%提升到46.8%。同时,外观和动作特征的结合比单独使用任一种特征都更有效,证明了解耦设计的合理性。

五、算法的深层工作机制

为了更好地理解DMA算法的工作原理,研究团队还进行了可视化分析。他们使用t-SNE技术将高维的特征向量投影到二维空间,就像制作一张特征地图来展示不同样本之间的关系。

可视化结果显示了一个有趣的现象:在没有使用DMA解耦技术时,相同物体类别的样本倾向于聚集在一起,不管它们执行什么动作。这就像一个只认识人脸的系统,会把同一个人的所有照片放到一起,不管这个人在做什么。

而使用DMA技术后,情况发生了根本性的改变。现在,执行相同动作的样本开始聚集在一起,即使它们来自不同的物体类别。这证明了算法成功地学会了基于动作而非外观来组织和理解视频内容。这种变化就像一个学会了按照行为而非外貌来分类的智能系统。

研究团队还提供了一些具体的应用案例来展示算法的实际效果。在一个特别有挑战性的例子中,支持集包含一只猫弹钢琴和一个人吹长笛的视频,而查询视频显示一个人在弹钢琴。传统方法会错误地将查询视频与支持集中的"人吹长笛"匹配,因为它们都涉及人类。但DMA算法能够正确识别出"弹钢琴"这个共同的动作模式,实现准确的分割。

另一个有趣的案例涉及时间相关的动作。支持集显示手指从捏合到张开的动作,而查询视频显示相反的过程(从张开到捏合)。虽然动作方向相反,但DMA算法仍然能够识别出这种细粒度的手部动作模式,展现了其对时间动态的深度理解能力。

六、实际应用前景与挑战

这项研究的实际应用前景非常广阔。在视频编辑领域,MOVE技术可以帮助编辑人员快速找到特定动作的镜头,大大提高工作效率。比如,在制作一部关于足球的纪录片时,编辑可以通过提供几个"射门"动作的示例,让系统自动从海量素材中找出所有相关镜头。

在体育分析方面,教练和分析师可以使用这个系统来研究运动员的技术动作。通过输入标准动作的示例,系统可以自动识别和分析运动员在比赛中的相应动作,为技术改进提供客观依据。这就像有了一个永不疲倦的助理教练,能够从无数比赛录像中找出值得研究的关键时刻。

在安防监控领域,MOVE技术可以用于行为分析和异常检测。通过学习正常行为模式,系统可以自动识别出可疑或异常的行为,提高安全监控的效率和准确性。这种应用就像给监控系统配备了一个经验丰富的安保专家的眼睛和判断力。

不过,研究团队也诚实地指出了当前技术的一些局限性。首先,对于背景信息的处理仍然有改进空间。当查询视频的背景环境与支持集差异很大时,系统有时会受到干扰。比如,在篮球场上踢足球这种场景下,系统可能会被背景环境误导。

其次,对于非常细粒度的动作区分,系统的表现还有提升余地。虽然它能够区分大的动作类别,但对于同一大类下的细微差异,识别准确性还需要进一步提高。这就像一个刚入门的舞蹈学生,虽然能够区分不同的舞种,但对于同一舞种内的不同风格还需要更多练习。

七、技术创新的深层意义

从更深层的角度来看,这项研究代表了人工智能在视频理解领域的一个重要范式转变。传统的视频分析方法主要继承了图像处理的思路,将视频视为静态图像的序列。而MOVE的方法真正把时间维度作为第一公民来对待,这种思路上的转变具有深远的意义。

这种范式转变可以类比为从拍照到摄影的进步。拍照关注的是某个瞬间的静态美,而摄影则要考虑时间的流逝、动作的连贯性和故事的叙述。MOVE技术正是让人工智能从"拍照"的思维模式进化到了"摄影"的理解层次。

研究团队的工作也为少样本学习领域带来了新的思路。传统的少样本学习主要关注如何从少量样本中学习物体的视觉特征,而MOVE展示了如何从少量样本中学习行为模式。这种从"学习看"到"学习理解"的转变,为人工智能的发展开辟了新的方向。

更重要的是,这项研究展示了跨领域知识融合的威力。研究团队巧妙地结合了计算机视觉、模式识别、时间序列分析等多个领域的技术,创造出了解决新问题的有效方案。这种跨领域的创新思路值得其他研究者借鉴和学习。

八、未来发展方向与展望

研究团队在论文中也描绘了这个领域未来可能的发展方向。首先是复杂动作的分解问题。现实中的很多动作都是由多个基本动作组合而成的,如何将复杂动作分解为更基本的"元动作",将是一个有趣且重要的研究方向。这就像学习语言时,我们先学会基本的词汇,然后组合成复杂的句子和段落。

其次是关系动作的建模。很多有意义的动作都涉及多个对象之间的交互,比如拥抱、握手、传球等。如何让系统理解这种多对象的关系动作,将是另一个重要的挑战。这需要系统不仅能理解单个对象的动作,还要理解对象之间的空间和时间关系。

长时间动作的建模也是一个值得探索的方向。目前的系统主要针对相对短暂的动作片段,但现实中很多有意义的行为都是长时间的过程,比如做饭、整理房间等。如何在计算效率和理解深度之间找到平衡,将是技术发展的重要课题。

背景理解的改进也是未来工作的重点。当前系统在处理复杂背景时还有不足,如何更好地区分前景动作和背景噪声,将直接影响系统的实用性。这就像训练一个在嘈杂环境中仍能专注于重要信息的专家。

最后,研究团队还提到了计算效率的优化问题。虽然当前的算法在准确性上表现出色,但在实际部署时还需要考虑计算资源的限制。如何在保持性能的同时提高运行效率,将是工程化应用的关键挑战。

说到底,复旦大学团队的这项研究为我们打开了一扇通向更智能视频理解的大门。他们不仅创建了一个宝贵的数据资源,更重要的是提出了一种全新的思考方式:让机器像人类一样理解动作的本质,而不仅仅是记住外表的特征。

这种从"看得见"到"看得懂"的进步,可能会在不久的将来改变我们与视频内容交互的方式。从更加智能的视频搜索,到更精准的体育分析,再到更可靠的安防监控,这项技术的影响将会渗透到我们生活的方方面面。当然,就像任何科学研究一样,这只是一个开始,真正的应用还需要更多研究者的共同努力和持续改进。

对于那些对这个领域感兴趣的读者,可以通过访问https://henghuiding.com/MOVE/获取更详细的技术资料和开源代码,亲自体验这项技术的魅力。科学的进步正是在这种开放共享的精神下不断前行的。

Q&A

Q1:MOVE数据集跟现有的视频数据集有什么不同? A:MOVE数据集的最大不同在于它关注的是动作模式而不是物体类别。传统数据集会标注"这是猫"、"这是人",而MOVE标注的是"在跳舞"、"在拥抱"。它包含224个动作类别、4300个视频、26万多帧画面,专门为训练能理解动作的AI系统而设计。

Q2:这个技术能不能用在日常的视频剪辑中? A:完全可以。这项技术最直接的应用就是智能视频剪辑。你只需要给系统展示几个"跳跃"动作的例子,它就能从你的海量素材中自动找出所有跳跃的镜头,不管是人跳、动物跳还是在什么场景下跳。这会大大提高视频编辑的效率,特别适合制作体育、舞蹈或动作类内容。

Q3:DMA算法的"解耦"是什么意思?为什么要这样设计? A:解耦就像教两个学生分工合作:一个专门记住物体长什么样(外观特征),另一个专门记住物体在做什么动作(动作特征)。这样设计的好处是,当我们需要找相同动作时,系统会主要听"动作专家"的意见,而不会被外观差异干扰。比如找"踢球"动作时,不管是大人踢还是小孩踢,系统都能准确识别。

- 上一篇:恋与深空

- 下一篇:台湾网红馆长直播游大陆吓坏了谁